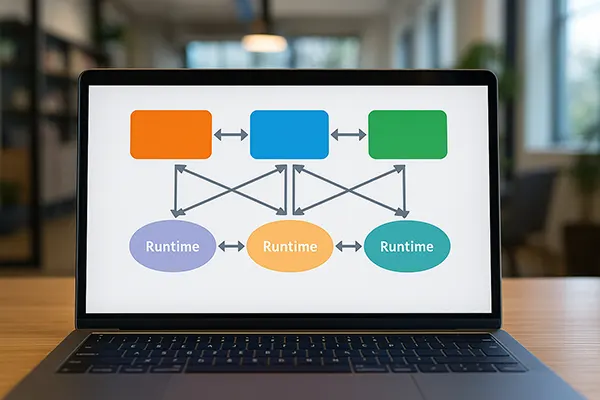

Aplikacje wieloruntime: podejścia do łączenia różnych środowisk uruchomieniowych w jednym projekcie

Tworzenie nowoczesnego systemu programistycznego często wymaga łączenia wielu języków, środowisk wykonawczych oraz silników uruchomieniowych. Zespoły decydują się na taką architekturę, aby osiągnąć równowagę pomiędzy wydajnością, utrzymaniem oraz skalowalnością. Konstrukcja wieloruntime umożliwia każdemu komponentowi działanie w środowisku najlepiej dopasowanym do jego funkcji, jednak jednocześnie stawia szereg wyzwań wymagających precyzyjnego planowania oraz świadomych decyzji inżynieryjnych.

Dobór środowisk uruchomieniowych w architekturze wieloruntime

Pierwszym etapem jest określenie, dlaczego dane środowisko jest potrzebne i jaki problem rozwiązuje. Niektóre języki zapewniają bardzo wysoką wydajność, inne sprawdzają się w obsłudze zadań asynchronicznych, a jeszcze inne oferują dojrzałe biblioteki dla konkretnych zastosowań. Wybór środowiska bez analizy długoterminowych potrzeb prowadzi do nadmiernego długu technicznego, dlatego decyzje powinny wynikać z rzeczywistych danych dotyczących wydajności oraz wymagań operacyjnych.

Kolejnym aspektem jest dopasowanie do umiejętności zespołu oraz możliwości utrzymania projektu. Wprowadzenie środowiska, którego zespół nie zna, znacząco podnosi koszt wdrożenia i spowalnia proces tworzenia oprogramowania. Organizacje najczęściej korzystają z kombinacji popularnych środowisk, takich jak Node.js, Python, Go, Java czy .NET, uzupełniając je językami niskopoziomowymi lub WebAssembly tam, gdzie to konieczne.

Istotnym elementem jest także zgodność z infrastrukturą oraz warunkami działania. Środowisko musi odpowiadać wymaganiom klastrów, ustawieniom orkiestracji kontenerów oraz przewidywanemu obciążeniu. Rzetelne testy pozwalają ocenić, jak różne środowiska zachowują się przy realnym ruchu, uwzględniając czasy startu, pracę pod dużą liczbą równoległych żądań oraz zużycie pamięci.

Ocena wymagań integracyjnych pomiędzy środowiskami

Po wyborze środowisk konieczne jest określenie, jak będą się one komunikować. Strategia wymiany danych decyduje o stabilności oraz szybkości całego systemu. Najczęściej stosuje się REST, gRPC, kolejki komunikatów lub formaty binarne zoptymalizowane pod dużą przepustowość. Niewłaściwy wybór może spowodować opóźnienia oraz niepotrzebne obciążenie systemu.

Modele danych muszą pozostawać spójne. Różnice pomiędzy typami danych, sposobem parsowania lub obsługą błędów mogą powodować trudne do wykrycia problemy. Dlatego zespoły często stosują wspólne schematy, takie jak Protocol Buffers, OpenAPI lub Avro, aby wymusić jednolitość danych w całej aplikacji.

Ważnym elementem integracji jest też bezpieczeństwo. Każde środowisko posiada odrębne ryzyka, dlatego komunikacja musi być chroniona na każdym etapie. Obejmuje to tokeny uwierzytelniające, szyfrowane kanały, limity żądań oraz spójne raportowanie błędów. Zapewnienie jednolitego podejścia do zabezpieczeń pomaga uniknąć powstawania słabych punktów w infrastrukturze.

Zarządzanie operacyjne systemami wieloruntime

Po zapewnieniu komunikacji pomiędzy środowiskami uwaga przenosi się na operacje. Pipeline’y wdrożeniowe muszą obsługiwać niezależne budowanie komponentów, ale jednocześnie dostarczać spójny proces dostarczania aplikacji. Najczęściej stosuje się konteneryzację, ponieważ izoluje środowiska, a jednocześnie zachowuje powtarzalność procesu wdrażania.

Monitorowanie wymaga narzędzi zdolnych do obserwacji wielu środowisk jednocześnie. Prometheus, OpenTelemetry czy Loki umożliwiają gromadzenie metryk, logów i śladów w jednym formacie. Jest to kluczowe, ponieważ każde środowisko generuje inny typ danych diagnostycznych, a pełny obraz systemu jest niezbędny do wykrywania problemów obejmujących kilka komponentów.

Zarządzanie konfiguracją staje się bardziej wymagające. Każde środowisko może wymagać odmiennych ustawień, zmiennych środowiskowych oraz wersji zależności. Aby utrzymać stabilność, organizacje korzystają ze scentralizowanych repozytoriów konfiguracji, jak Consul czy Kubernetes ConfigMaps, co zapewnia spójność ustawień.

Testowanie i zapewnianie jakości w systemach wieloruntime

Testowanie obejmuje nie tylko logikę wewnętrzną, ale również sposób, w jaki środowiska współpracują. Testy kontraktowe pomagają zweryfikować zgodność modeli danych, a scenariusze end-to-end ujawniają problemy, które nie wystąpią w izolowanych testach jednostkowych. W systemach wieloruntime rośnie ryzyko błędów integracyjnych.

Testy wydajności powinny obejmować zarówno zachowanie poszczególnych środowisk, jak i wydajność całego systemu. Wąskie gardła często pojawiają się na granicach komunikacji. Analiza opóźnień pozwala lepiej zrozumieć segmenty wymagające optymalizacji.

Testy niezawodności wymagają symulowania awarii, takich jak nagłe przerwanie procesu czy przeciążenie sieci. Każde środowisko może reagować inaczej, dlatego system musi być odporny na nieprzewidywalne zachowania jednego komponentu.

Skalowanie i utrzymanie długoterminowe

Skalowanie aplikacji wieloruntime wymaga jasnego rozdziału odpowiedzialności. Komponenty działające w różnych środowiskach powinny skalować się niezależnie, aby uniknąć niepotrzebnego obciążania całego systemu. Skalowanie poziome jest typowe dla zadań o dużej równoległości, natomiast zadania zasobożerne mogą wymagać skalowania pionowego.

Zarządzanie zależnościami staje się szczególnie istotne, ponieważ środowiska ewoluują w różnym tempie. Niektóre mają częste aktualizacje, inne funkcjonują w cyklu LTS. Synchronizacja strategii aktualizacji minimalizuje ryzyko niezgodności oraz zapewnia przewidywalność w procesie wdrażania.

Utrzymanie długoterminowe wymaga odpowiedniej dokumentacji oraz wymiany wiedzy w zespole. Złożoność architektury rośnie wraz z liczbą środowisk, dlatego konieczne jest tworzenie jasnych wytycznych, diagramów oraz procedur obsługi. Dzięki temu zespół może sprawnie utrzymywać system przez cały okres jego rozwoju.

Ocena przyszłości architektury wieloruntime

Sektor technologiczny szybko się zmienia, a narzędzia takie jak WebAssembly, rozproszone środowiska wykonawcze czy optymalizacje wspierane przez sztuczną inteligencję upraszczają korzystanie z wielu środowisk jednocześnie. Zmniejszają one koszty operacyjne i ułatwiają dobór języków do konkretnych zadań.

Kolejnym kierunkiem rozwoju są zaawansowane możliwości orkiestracji. Nowoczesne platformy kontenerowe pozwalają precyzyjniej zarządzać zasobami środowisk, co zwiększa efektywność kosztową oraz wydajność systemu.

Architektury wieloruntime będą się rozwijać wraz ze wzrostem potrzeb inżynieryjnych. Nie stanowią już eksperymentu, lecz praktyczne rozwiązanie dla złożonych projektów. Przy świadomym planowaniu oraz rzetelnych decyzjach technicznych możliwe jest tworzenie stabilnych i skalowalnych systemów korzystających z zalet wielu środowisk jednocześnie.